목표: Linear RAID, RAID0, RAID1, RAID5 장치의 고장 난 하드디스크를 새로운 하드디스크로 교체해 본다.

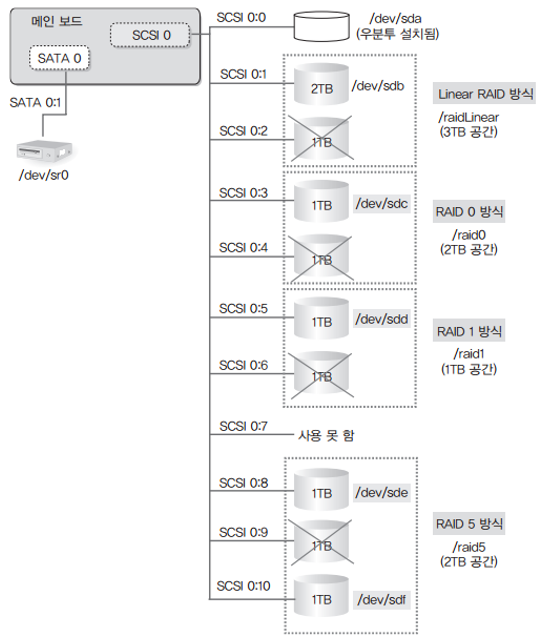

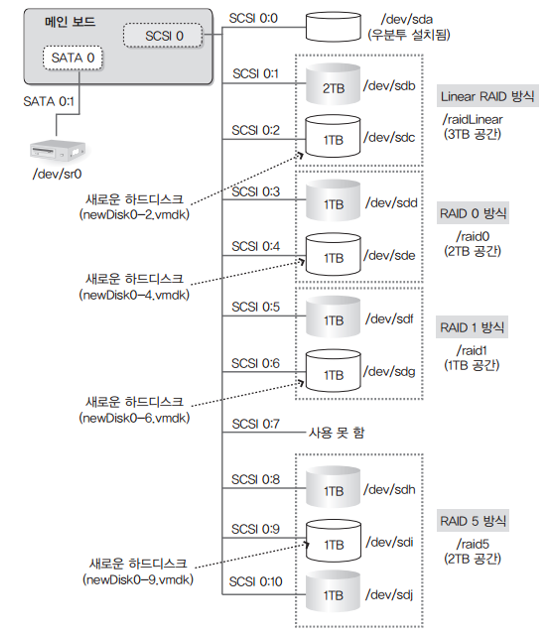

-복구 전후의 내부적 변화 도식화

고장 난 장치를 새로운 하드디스크로 교체합니다.

[Vmware Workstaton 15 player] 창에서 [server] 가상머신을 선택한 후 [Edit Virtual Machine setting]를 클릭해서 4개의 하드디스크를 추가합니다.

새로운 하드디스크를 추가했다고 자동으로 RAID 장치가 복구되는 것은 아닙니다. 직접 수동으로 복구해야 합니다.

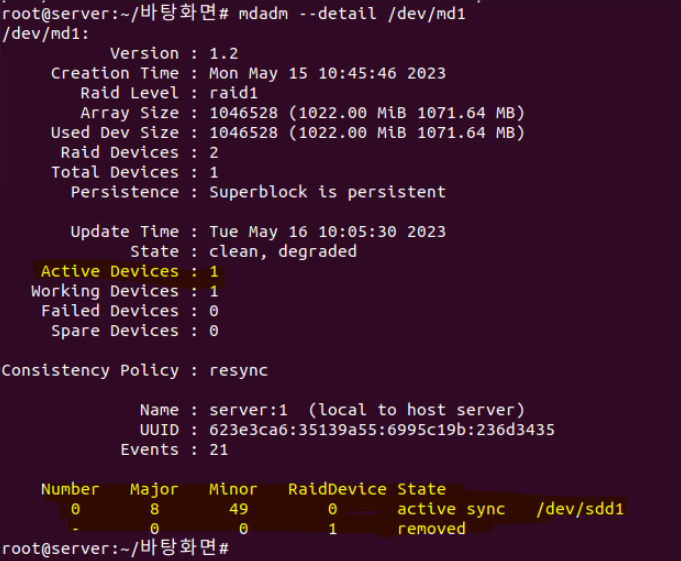

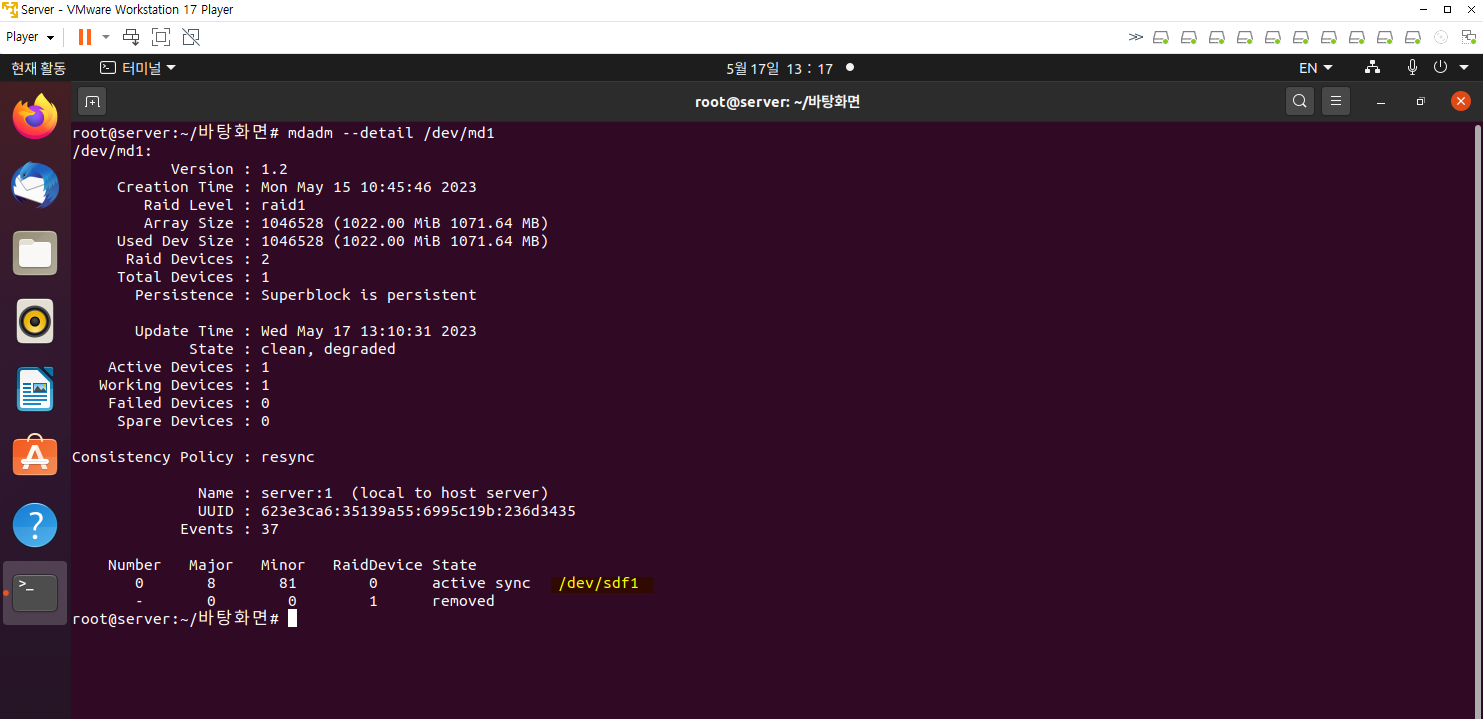

먼저 mdadm --detail /dev/md1 명령으로 RAID1 장치의 구성을 다시 살펴봅니다.

자동으로 복구되지는 않았지만 새 하드디스크를 교체하기 전과 약간의 차이점을 확인할 수 있습니다.

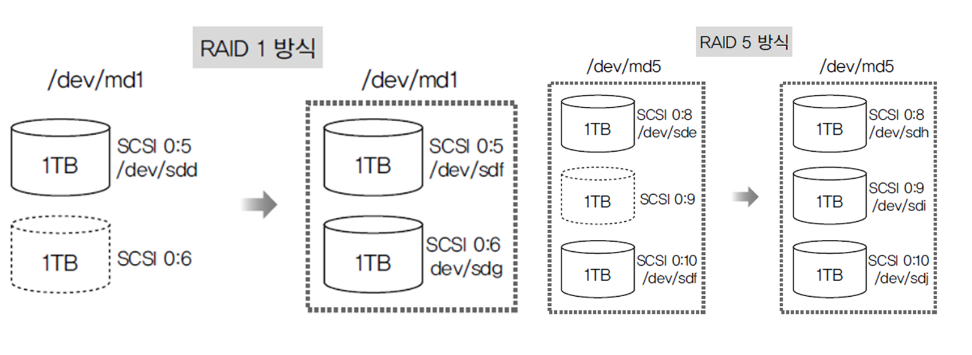

비교하면 장치가 /dev/sdd에서 /dev/sdf로 변했다는 것을 알 수 있습니다.

우선 새로운 하드디스크를 이용해서 Linear RAID, RAID0, RAID1, RAID5를 복구합니다.

새로운 하드디스크 /dev/sdc(SCST 0:2)의 파일 시스템을 만듭니다.

같은 방법으로 하드디스크 /dev/sde(SCSI 0:4), /dev/sdg(SCSI 0:6). /dev/dsi(SCSI 0:9) 파일을 만듭니다.

Is /dev/sd* 명령으로 모든 파티션이 작성되었는지 확인합니다.

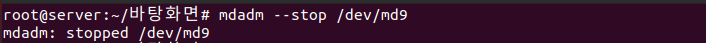

mdadm --stop /dev/md9 명령으로 Linear RAID 장치(/dev/md9)를 중지하고, mdadm --create /dev/md9 --level==linear --raid-devices=2 /dev/sdb1 /dev/sdc1 명령으로 다시 구성합니다.

확인 메시지가 나오면 y를 입력합니다.

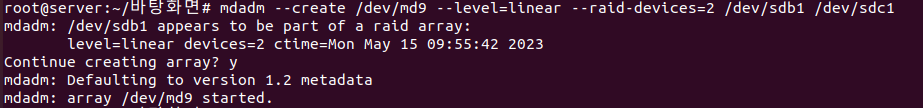

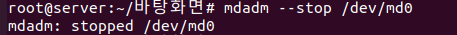

위와 마찬가지로 /dev/md0 역시 같은 방식으로 진행합니다.

이번에는 결함 허용이 있는 RAID 1,5를 구성합니다.

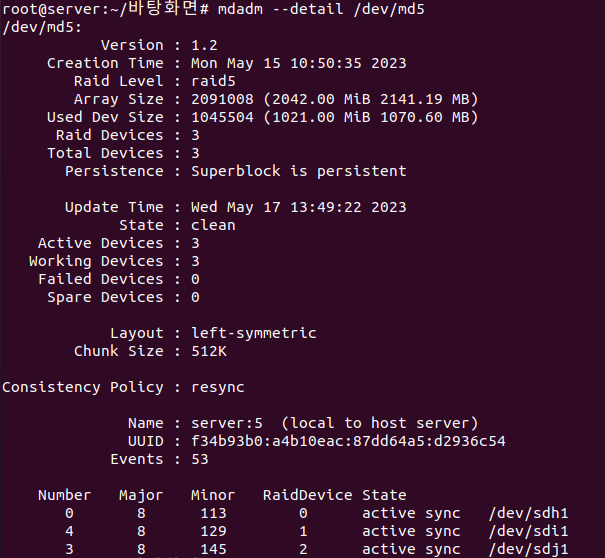

mdadm --detail /dev/md1 명령과 mdadm --detail /dev/md5 명령으로 두 RAID 장치가 제대로 작동하는 확인 합니다.

RAID5를 통해 완전히 작동하는 것을 알 수 있습니다.

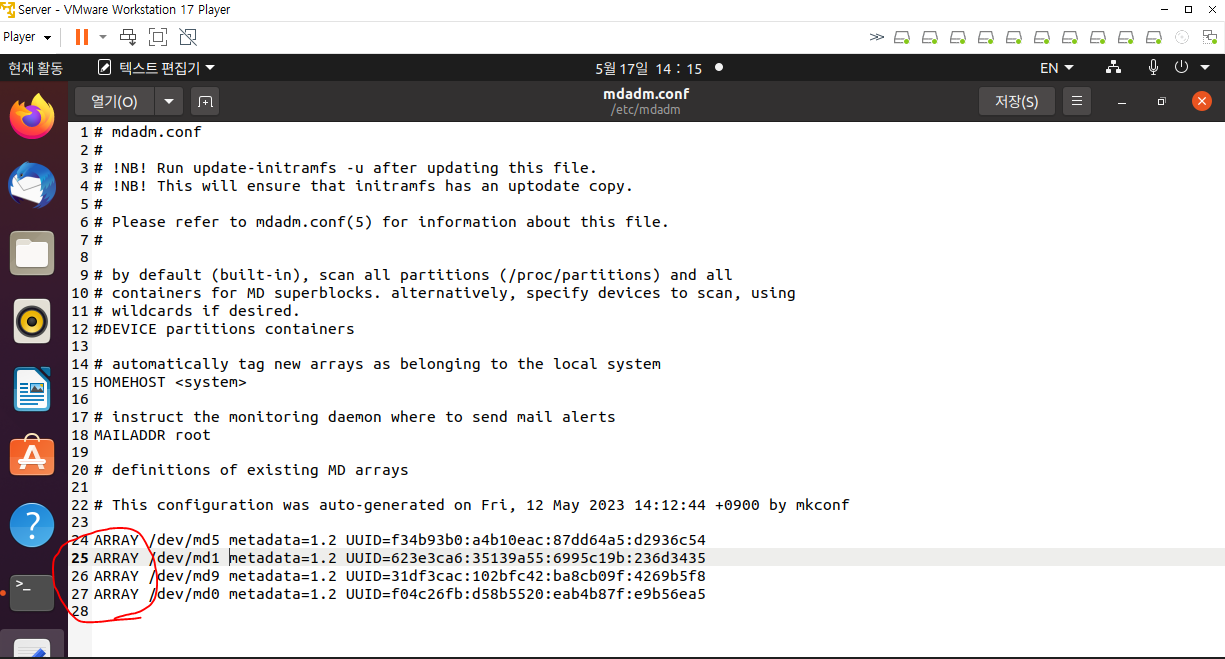

gedit를 이용해 mdadm.conf로 들어가 주석처리가 되어 있는 부분을 삭제합니다.

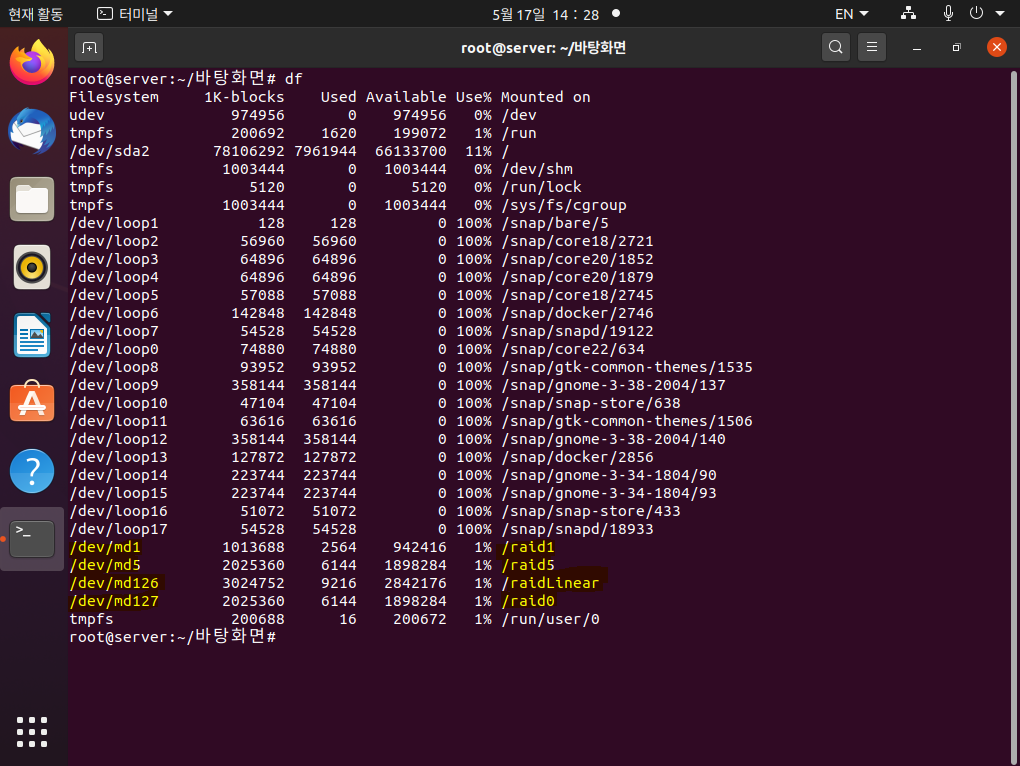

df 명령어를 입력하면 RAID1(/dev/md1)과 RAID5(/dev/md5)가 생성된 것을 볼 수 있습니다.

앞의 실습에서는 RAID1과 RAID5는 새로운 하드디스크를 추가하기 전과 후에 모두 데이터가 존재하기 때문에, 사용자 입장에서는 겉으로 보기에는 변화가 없는 것 같지만 내부적으로는 아래와 같은 변화가 발생했습니다.

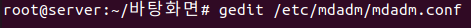

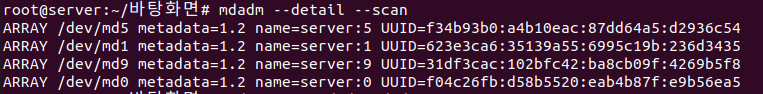

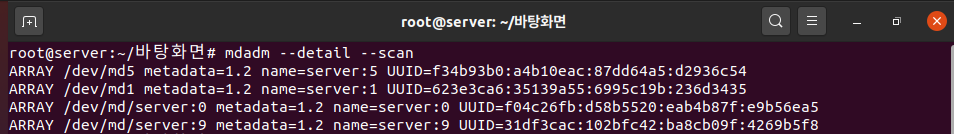

재부팅을 하고 다시 위에 입력한 명령어 mdadam --datail --scan을 입력합니다.

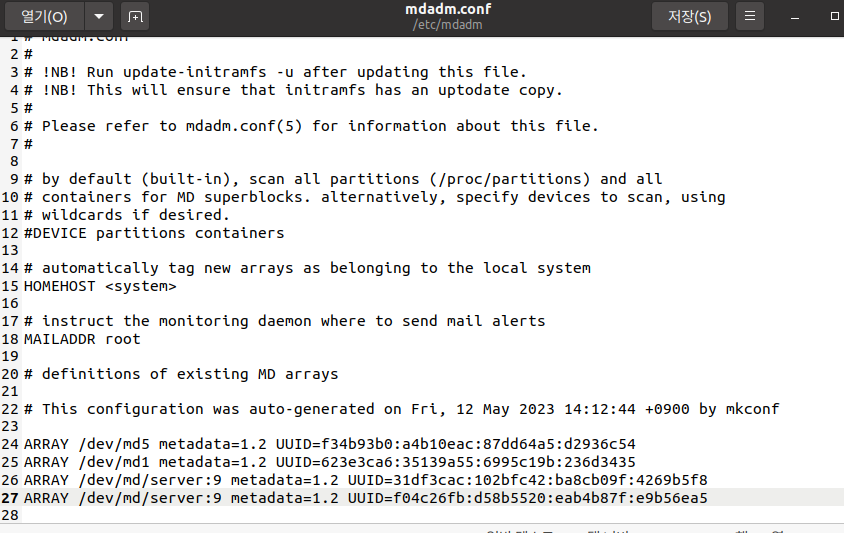

추가되었지만 md0과 md9는 재구 조하느라 이름이 바뀌어 있습니다. 따라서 이름을 새로 생성해야 합니다.

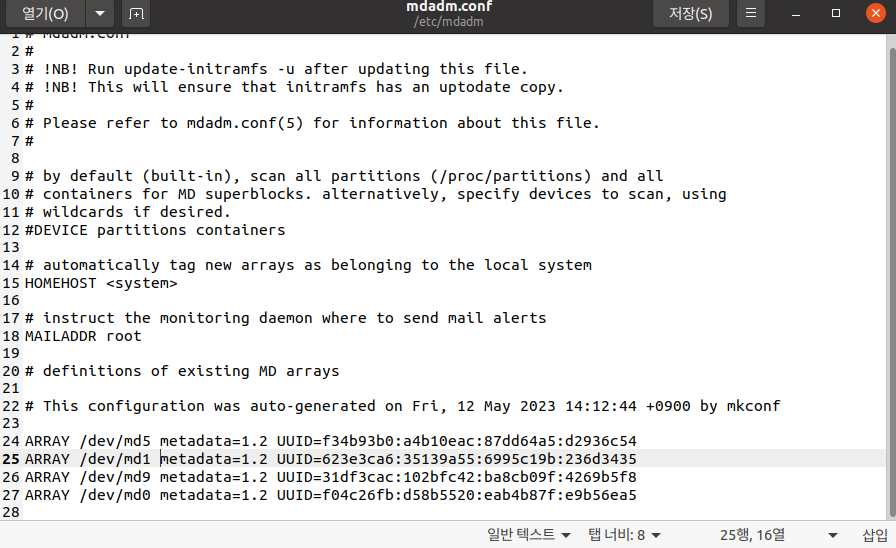

gedit를 이용해 mdadm.conf로 들어가 주석처리가 되어 있는 부분을 삭제합니다.

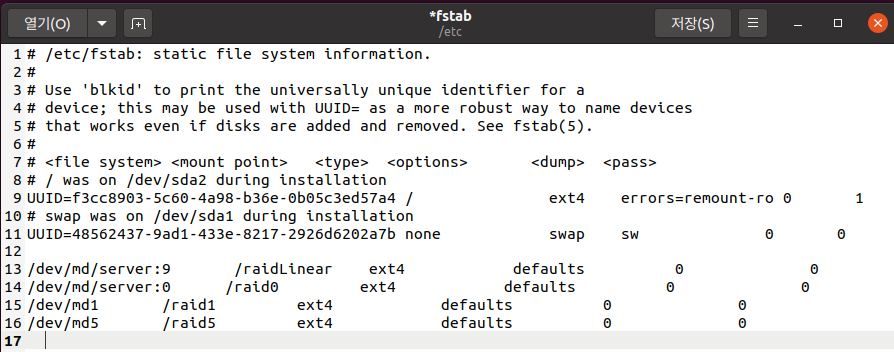

gedit /etc/fstab로 들어가서 역시 이름을 수정합니다.

df로 들어가면 추가적으로 RAID가 구성되어 있는 것을 볼 수 있습니다.

이상으로 하드디스크 교체에 대한 설명을 마치겠습니다. 감사합니다.

'서버 > 리눅스 실습' 카테고리의 다른 글

| [LVM] LVM 개념의 이해 (0) | 2023.05.22 |

|---|---|

| [RAID] 고급 RAID 레벨, RAID6과 RAID 1+0의 개념 (0) | 2023.05.19 |

| RAID 문제 발생 테스트_RAID1, RAID5 (0) | 2023.05.16 |

| RAID 구축 실습_Linear RAID, RAID0, RAID1,RAID5 구현 (0) | 2023.05.15 |

| 하드디스크 설치하기_Fdisk, RAID (0) | 2023.05.12 |